El Meta Llama 3.1 405B se ha anunciado oficialmente y ya se ha hecho un nombre antes de que se lanzaran sus capacidades de inteligencia artificial. Desarrollado por Meta, este modelo de vanguardia ofrece una flexibilidad, un control y un rendimiento sin precedentes para competir con los mejores modelos de inteligencia artificial de código cerrado.

Ayer, algunos usuarios pudieron disfrutar de un adelanto de su potencial y hoy tenemos pruebas de rendimiento oficiales que destacan sus impresionantes capacidades. También puedes leer más sobre las revelaciones de ayer aquí.

¿Qué es Meta Llama 3.1 405B?

Hoy aprenderemos todo lo que hay que saber sobre Meta Llama 3.1 405B. Llama 3.1 405B es una IA de código abierto que se destaca en una variedad de tareas, como conocimiento general, navegabilidad, matemáticas, uso de herramientas y traducción multilingüe, mientras que las versiones de nivel medio 70B y nivel mínimo 8B también se destacan en sus respectivas clases. Con una longitud de contexto de 128K y soporte para ocho idiomas, este modelo está diseñado para manejar aplicaciones complejas y diversas.

Llama 3.1 405B, entrenado con más de 15 billones de tokens y más de 16 mil GPU H100, se destaca como uno de los modelos de IA más potentes y capaces disponibles. Se ha invertido mucha energía en esta IA. Ahora podemos empezar a ponernos técnicos.

Características principales de Meta Llama 3.1 405B

Meta Llama 3.1 405B ofrece varias funciones avanzadas:

- Longitud de contexto extendida:Admite una longitud de contexto de hasta 128K, ideal para resúmenes de texto extensos y conversaciones complejas.

- Capacidades multilingües:Maneja múltiples idiomas, lo que lo hace versátil para aplicaciones globales.

- Uso avanzado de herramientas:Capaz de integrarse con varias herramientas para una funcionalidad mejorada.

- Generación de datos sintéticos:Facilita la creación de datos sintéticos para mejorar y entrenar modelos más pequeños.

- Destilación modelo:Permite la destilación de modelos grandes en versiones más pequeñas y eficientes.

Meta se ha asociado con más de 25 empresas para facilitar el uso de Meta Llama 3.1 405B. Este apoyo del ecosistema hace que sea más factible para los desarrolladores e investigadores trabajar con este poderoso modelo, incluso sin acceso a recursos computacionales masivos.

Cómo utilizar Meta Llama 3.1 405B

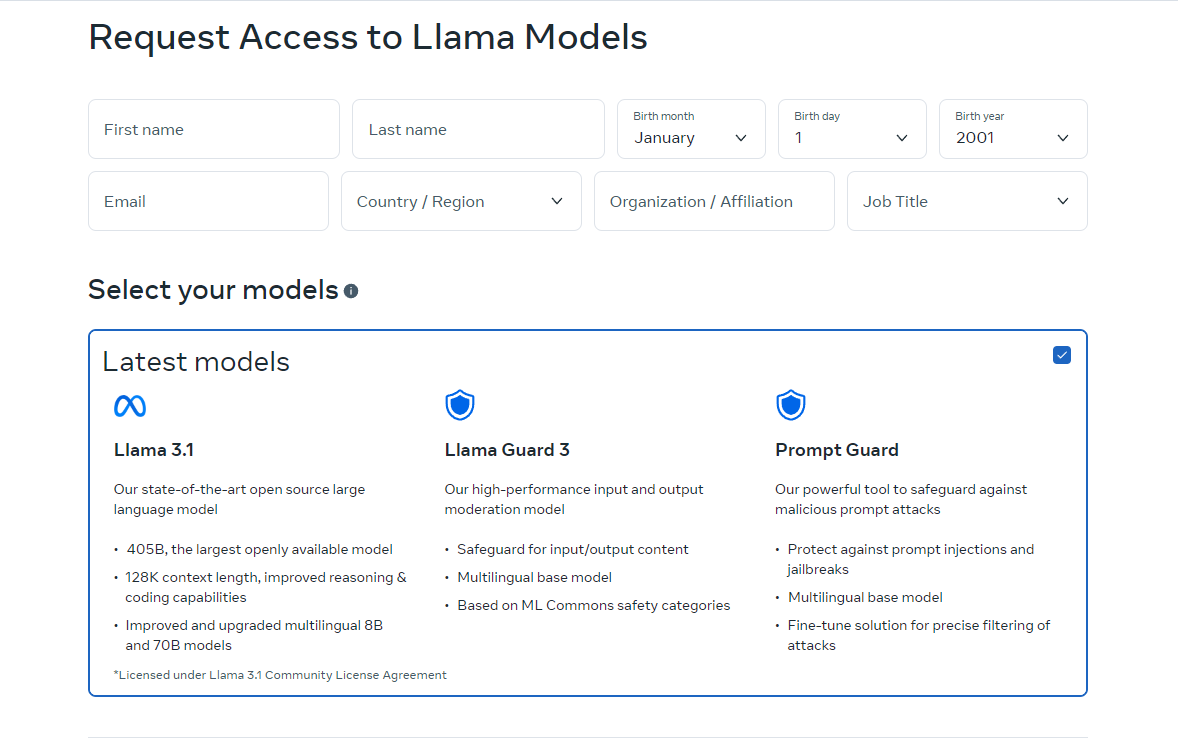

Para comenzar a utilizar Meta Llama 3.1 405B, siga estos pasos:

- Acceder al modelo:Visite llama.meta.com o Hugging Face para descargar el modelo. Estas plataformas proporcionan los archivos y la documentación necesarios para comenzar.

- Configura tu entorno:Asegúrese de contar con un entorno adecuado para ejecutar el modelo. Esto incluye contar con el hardware necesario, como GPU, y dependencias de software como Python y PyTorch.

- Cargar el modelo:Utilice los fragmentos de código y las pautas que se proporcionan para cargar el modelo en su aplicación. Meta proporciona instrucciones detalladas para ayudarlo a integrar Llama 3.1 405B en sus proyectos.

- Ejecutar inferencia: Comience a utilizar el modelo para inferencias en tiempo real o por lotes. Puede hacerle preguntas al modelo, generar texto o realizar traducciones utilizando sus potentes capacidades.

- Ajustar para tareas específicas:Si es necesario, puede ajustar el modelo para aplicaciones específicas mediante técnicas de ajuste supervisado. Meta ofrece recursos y ejemplos para guiarlo en este proceso.

La versión en línea de Llama actualmente solo está disponible en ciertos países. Sin embargo, también puedes usarla localmente descargando los códigos de fuente abierta. Las instrucciones de descarga están disponibles en los sitios a los que te dirigimos. También puedes usar Meta Llama 3.1 405B a través de Grog.

Cómo usar Meta Llama 3.1 405B en Groq

Meta Llama 3.1 405B, el modelo de base abierta más grande y con más capacidad hasta la fecha, ya está disponible en Groq. Esta guía le ayudará a comenzar a utilizar Meta Llama 3.1 405B en Groq.

Paso 1: Consola de desarrollo de GroqCloud

- Registrate e inicia secion:Visite la consola de desarrollo de GroqCloud y regístrese o inicie sesión en su cuenta.

- Encuentra modelos de Meta Llama 3.1: Navega hasta la sección de modelos y busca Meta Llama 3.1 405B. También encontrarás disponibles los modelos 70B y 8B Instruct.

- Obtener una clave API:Obtenga una clave API de Groq gratuita desde la consola. Esta clave le permitirá interactuar con el modelo.

Chat Groq

Para el acceso del público en general, puede utilizar GroqChat:

- Visita GroqChat:Vaya a GroqChat para interactuar directamente con Meta Llama 3.1 405B.

- Explorar funciones:Pruebe las capacidades del modelo en tiempo real, como generar texto, traducciones o responder consultas.

Paso 2: Configuración de su entorno

Requisitos de hardware y software

- HardwareAsegúrese de tener el hardware adecuado, preferiblemente GPU, para manejar los requisitos del modelo.

- Software: Instale las dependencias de software necesarias, como Python y PyTorch. Puede encontrar instrucciones de configuración detalladas en la consola de desarrollo de GroqCloud.

Configuración del entorno

- Integración API:Reemplace su clave API estándar de la industria existente con la clave API de Groq.

- Establecer URL base:Configure su aplicación para utilizar la URL base de Groq para solicitudes de API.

Paso 3: Cargar y ejecutar el modelo

Cargando el modelo

- Fragmentos de código:Utilice los fragmentos de código proporcionados en la consola de desarrollo de GroqCloud para cargar Meta Llama 3.1 405B en su aplicación.

- Inicialización:Inicialice el modelo con la clave API y configure los parámetros necesarios para su caso de uso específico.

Inferencia en ejecución

- Inferencia en tiempo real:Comience a ejecutar inferencias en tiempo real enviando consultas al modelo y recibiendo respuestas.

- Procesamiento por lotes:Para tareas más grandes, puede utilizar el procesamiento por lotes para manejar múltiples consultas simultáneamente.

Paso 4: Ajustes para tareas específicas

- Datos de entrenamiento:Prepare su conjunto de datos para la aplicación específica para la que desea ajustar el modelo.

- Proceso de ajuste fino:Siga las instrucciones detalladas proporcionadas por Meta y Groq para ajustar el modelo utilizando técnicas supervisadas.

- Validación:Valide el modelo ajustado para garantizar que cumpla con los criterios de rendimiento deseados.

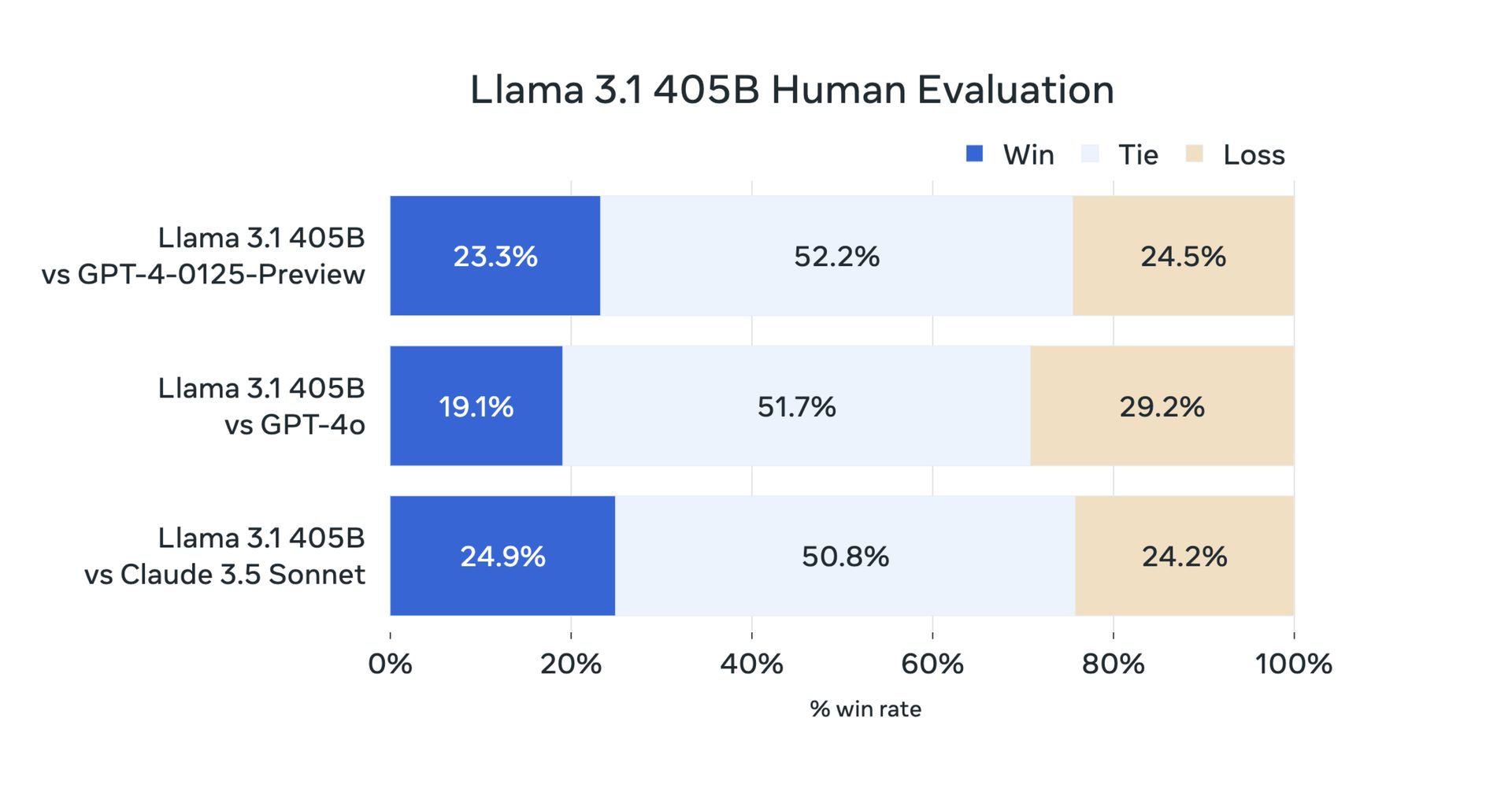

Meta Llama 3.1 405B: pruebas comparativas y rendimiento

Ayer, debido a su naturaleza de código abierto, los usuarios realizaron sus pruebas. Pero ahora las pruebas de referencia oficiales han confirmado que Meta Llama 3.1 405B tiene un rendimiento excepcional en una variedad de tareas. El modelo ha sido evaluado en más de 150 conjuntos de datos de referencia y comparado con modelos líderes como GPT-4 y Claude 3.5 Sonnet. Los resultados muestran que Llama 3.1 405B es competitivo con estos modelos superiores y ofrece un rendimiento de alta calidad en escenarios del mundo real.

En primer lugar, aquí están los puntos de referencia de Llama 3.1 8B y Llama 3.1 70B:

| Categoría | Punto de referencia | Llama 3.1 8B | Gemma 2 9B ES | Mistral 7B Instrucción | Llama 3.1 70B | Instrucciones Mixtral 8x22B | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| General | MMLU (0 disparos, CoT) | 73.0 | 72.3 | 60,5 | 86.0 | 79,9 | 69.8 |

| General | MMLU PRO (5 disparos, CoT) | 48.3 | – | 36.9 | 66.4 | 56.3 | 49.2 |

| General | IFEval | 80.4 | 73.6 | 57.6 | 87,5 | 72,7 | 69,9 |

| Código | Evaluación humana (0 disparos) | 72.6 | 54.3 | 40.2 | 80.5 | 75.6 | 68.0 |

| Código | MBPP EvalPlus (base) (0 disparos) | 72.8 | 71.7 | 49,5 | 86.0 | 78.6 | 82.0 |

| Matemáticas | GSM8K (8 disparos, CoT) | 84.5 | 76,7 | 53.2 | 95.1 | 88.2 | 81.6 |

| Matemáticas | MATEMÁTICAS (0-shot, CoT) | 51.9 | 44.3 | 13.0 | 68.0 | 54.1 | 43.1 |

| Razonamiento | Desafío ARC (0 disparos) | 83.4 | 87.6 | 74.2 | 94.8 | 88.7 | 83.7 |

| Razonamiento | GPQA (0 disparos, CoT) | 32.8 | – | 28.8 | 46.7 | 33.3 | 30.8 |

| Uso de herramientas | BFCL | 76.1 | – | 60.4 | 84.8 | – | 85.9 |

| Uso de herramientas | Nexo | 38.5 | 30.0 | 24.7 | 56,7 | 48,5 | 37.2 |

| Contexto largo | ZeroSCROLLS/Calidad | 81.0 | – | – | 90,5 | – | – |

| Contexto largo | InfiniteBench/En.MC | 65.1 | – | – | 78.2 | – | – |

| Contexto largo | NIH/Multiagujas | 98.8 | – | – | 97,5 | – | – |

| Plurilingüe | MGSM multilingüe (0 disparos) | 68,9 | 53.2 | 29.9 | 86.9 | 71.1 | 51.4 |

Y hay un benchmark Meta Llama 3.1 405B:

| Categoría | Punto de referencia | Llama 3.1 405B | Instrucción Nemotron 4 340B | GPT-4 (0125) | GPT-4 Omni | Soneto Claude 3.5 |

|---|---|---|---|---|---|---|

| General | MMLU (0 disparos, CoT) | 88.6 | 78,7 (no CoT) | 85.4 | 88.7 | 88.3 |

| General | MMLU PRO (5 disparos, CoT) | 73.3 | 62,7 | 64.8 | 74.0 | 77.0 |

| General | IFEval | 88.6 | 85.1 | 84.3 | 85.6 | 88.0 |

| Código | Evaluación humana (0 disparos) | 89.0 | 73.2 | 86.6 | 90.2 | 92.0 |

| Código | MBPP EvalPlus (base) (0 disparos) | 88.6 | 72.8 | 83.6 | 87.8 | 90,5 |

| Matemáticas | GSM8K (8 disparos, CoT) | 96.8 | 92.3 (0 disparos) | 94.2 | 96.1 | 96,4 (0 disparos) |

| Matemáticas | MATEMÁTICAS (0-shot, CoT) | 73.8 | 41.1 | 64,5 | 76.6 | 71.1 |

| Razonamiento | Desafío ARC (0 disparos) | 96.9 | 94.6 | 96.4 | 96.7 | 96.7 |

| Razonamiento | GPQA (0 disparos, CoT) | 51.1 | – | 41.4 | 53.6 | 59.4 |

| Uso de herramientas | BFCL | 88,5 | 86,5 | 88.3 | 80.5 | 90.2 |

| Uso de herramientas | Nexo | 58,7 | – | 50.3 | 56.1 | 45,7 |

| Contexto largo | ZeroSCROLLS/Calidad | 95.2 | – | – | 90,5 | 90,5 |

| Contexto largo | InfiniteBench/En.MC | 83.4 | – | 72.1 | 82,5 | – |

| Contexto largo | NIH/Multiagujas | 98.1 | – | 100.0 | 100.0 | 90.8 |

| Plurilingüe | MGSM multilingüe (0 disparos) | 91.6 | – | 85.9 | 90,5 | 91.6 |

Meta Llama 3.1 405B representa un avance en la IA de código abierto al brindarles a los desarrolladores e investigadores una herramienta poderosa para una variedad de aplicaciones. Con sus características avanzadas, su ecosistema sólido y su compromiso con el desarrollo responsable, esperamos que Llama 3.1 405B traiga innovaciones a las comunidades de IA 70B y 8B. Aquí está todo lo que hemos preparado para ti.

Crédito de la imagen destacada: Meta AI

Source: Todo lo que necesitas saber sobre Meta Llama 3.1 405B