Nvidia está revolucionando el mundo de la informática con inteligencia artificial con el reciente lanzamiento de NVIDIA H200. Esta plataforma de vanguardia, construida sobre NVIDIA Hopper arquitectura, cuenta con la potente GPU NVIDIA H200 Tensor Core, equipada con memoria avanzada diseñado para abordar cargas de datos sustanciales para cargas de trabajo de IA generativa y computación de alto rendimiento (HPC).

arquitectura, cuenta con la potente GPU NVIDIA H200 Tensor Core, equipada con memoria avanzada diseñado para abordar cargas de datos sustanciales para cargas de trabajo de IA generativa y computación de alto rendimiento (HPC).

En este artículo, profundizaremos en el lanzamiento reciente y brindaremos tantos detalles como sea posible sobre la nueva NVIDIA H200.

El poder de NVIDIA H200

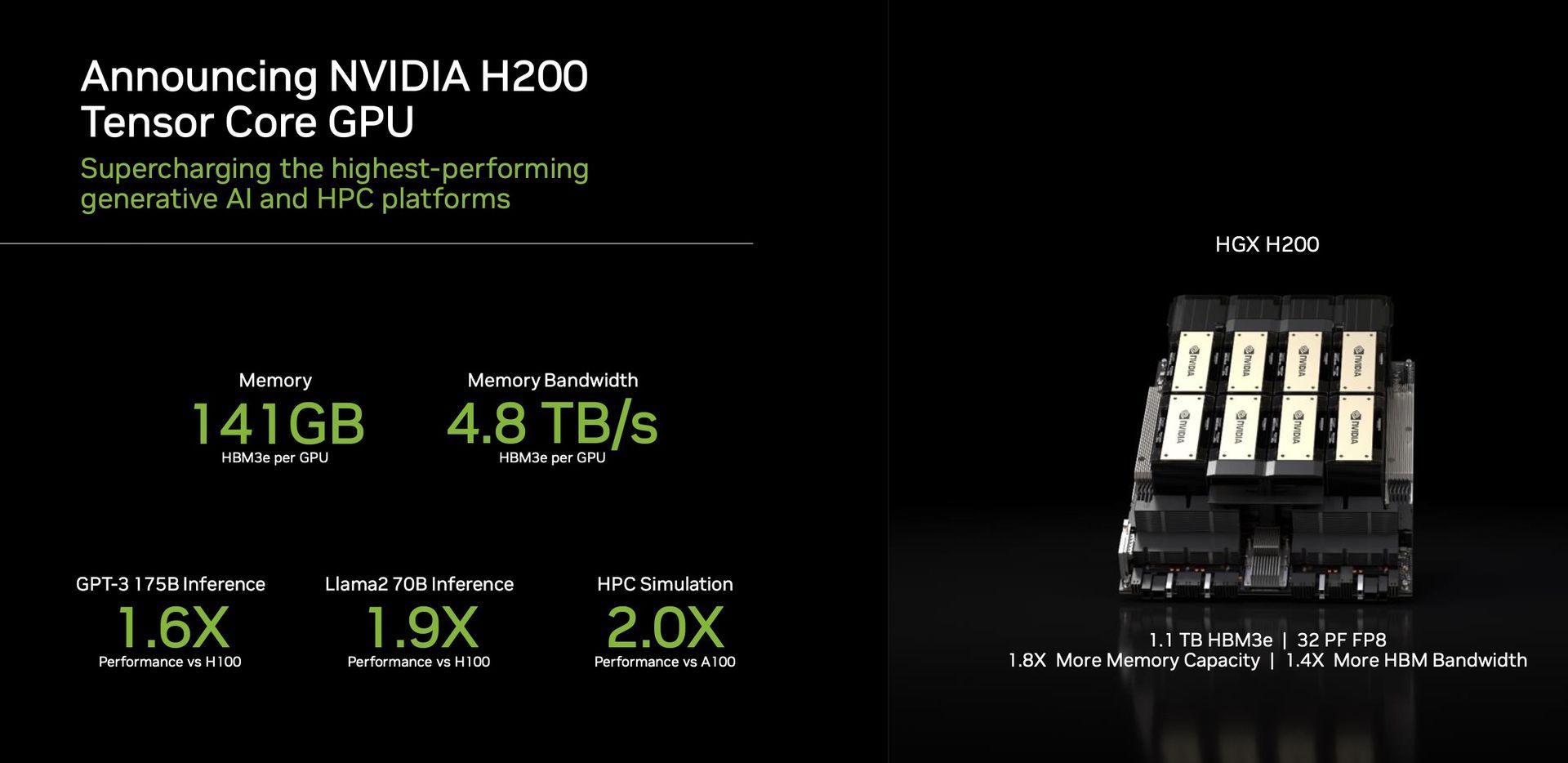

Una característica destacada del H200 es su utilización de HBM3e, la primera GPU que ofrece esta memoria más rápida y más grande. Este avance impulsa la aceleración de la IA generativa y los grandes modelos de lenguaje, ampliando simultáneamente los límites de la computación científica para cargas de trabajo HPC. Con HBM3e, el H200 ofrece una impresionante 141GB de memoria a un ritmo asombroso 4,8 terabytes por segundo. Esto representa casi el doble de capacidad y 2,4 veces más ancho de banda en comparación con su predecesora, la NVIDIA A100.

Rendimiento y aplicaciones

El H200, impulsado por NVIDIA NVLink y NVSwitch

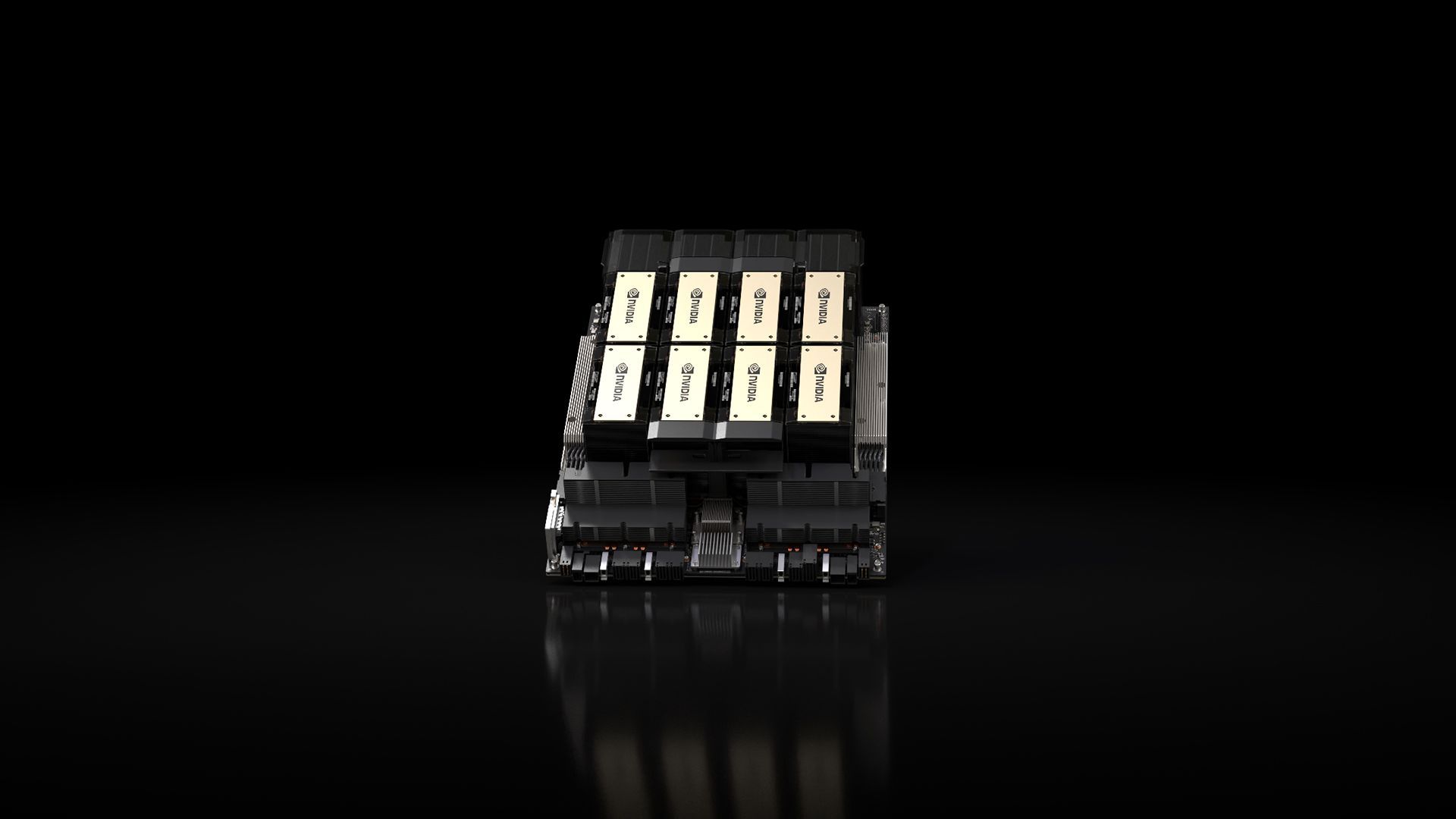

y NVSwitch interconexiones de alta velocidad, promesas rendimiento incomparable en varias cargas de trabajo de aplicaciones. Esto incluye su destreza en el entrenamiento LLM (Large Language Model) y la inferencia para modelos que superan una colosal 175 mil millones de parámetros. Un HGX H200 de ocho vías destaca por ofrecer más 32 petaflops de FP8 de profundidad aprendizaje computacional y una memoria agregada de gran ancho de banda de 1,1 TB, asegurando el máximo rendimiento en aplicaciones de IA generativa y HPC.

interconexiones de alta velocidad, promesas rendimiento incomparable en varias cargas de trabajo de aplicaciones. Esto incluye su destreza en el entrenamiento LLM (Large Language Model) y la inferencia para modelos que superan una colosal 175 mil millones de parámetros. Un HGX H200 de ocho vías destaca por ofrecer más 32 petaflops de FP8 de profundidad aprendizaje computacional y una memoria agregada de gran ancho de banda de 1,1 TB, asegurando el máximo rendimiento en aplicaciones de IA generativa y HPC.

Las GPU de Nvidia se han convertido esencial en el ámbito de los modelos generativos de IA, desempeñando un papel crucial en su desarrollo e implementación. Diseñadas para manejar cálculos paralelos masivos necesarios para entrenar y ejecutar estos modelos, las GPU de Nvidia destacan en tareas como generación de imágenes y lenguaje natural Procesando. La arquitectura de procesamiento paralelo permite que estas GPU funcionen numerosos cálculos simultáneamente, lo que resulta en una aceleración sustancial de los procesos del modelo generativo de IA.

El H200 es un testimonio del compromiso de Nvidia con saltos perpetuos de innovación y rendimiento. Aprovechando el éxito de la arquitectura Hopper, se están realizando mejoras de software continuas, incluido el reciente lanzamiento de bibliotecas de código abierto como NVIDIA TensorRT. -LLM, seguir elevando el rendimiento de la plataforma. La introducción de NVIDIA H200 promete nuevos avances, con expectativas de casi duplicar la velocidad de inferencia en modelos como Llama 2, un LLM de 70 mil millones de parámetros, en comparación con su predecesor, el H100.

-LLM, seguir elevando el rendimiento de la plataforma. La introducción de NVIDIA H200 promete nuevos avances, con expectativas de casi duplicar la velocidad de inferencia en modelos como Llama 2, un LLM de 70 mil millones de parámetros, en comparación con su predecesor, el H100.

Versatilidad y disponibilidad

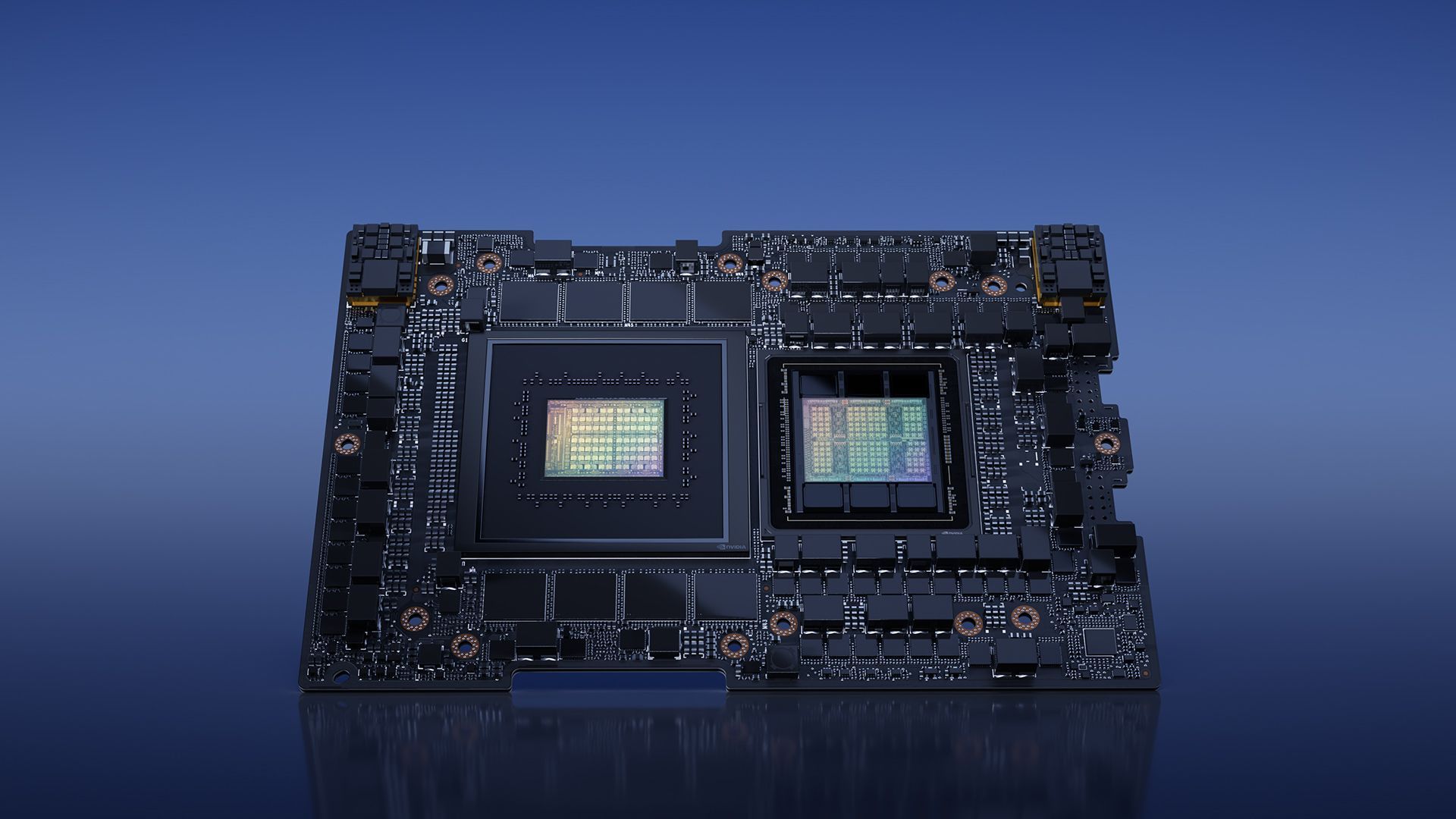

Nvidia asegura versatilidad con el H200, ofreciéndolo en varios factores de forma, como placas de servidor NVIDIA HGX H200 con configuraciones de cuatro y ocho vías. Estas configuraciones son compatibles tanto con el hardware como con el software de los sistemas HGX H100. Además, NVIDIA H200 está disponible en NVIDIA GH200 Grace Hopper Superchip con HBM3e, que se adapta a diferentes configuraciones de centros de datos, incluidos entornos locales, de nube, de nube híbrida y de borde. El ecosistema global de fabricantes de servidores asociados puede actualizar sin problemas sus sistemas existentes con el H200, garantizando una amplia accesibilidad.

Superchip con HBM3e, que se adapta a diferentes configuraciones de centros de datos, incluidos entornos locales, de nube, de nube híbrida y de borde. El ecosistema global de fabricantes de servidores asociados puede actualizar sin problemas sus sistemas existentes con el H200, garantizando una amplia accesibilidad.

Los entusiastas y expertos de la industria esperan ansiosamente el lanzamiento de los sistemas HGX H200, que llegarán al mercado en el segundo trimestre de 2024. Destacados actores globales como Amazon Web Services, Google Cloud, Microsoft Azure y Oracle Cloud Infrastructure se encuentran entre la primera ola de proveedores de servicios en la nube listo para implementar instancias basadas en H200 el próximo año.

arquitectura (crédito de la imagen)

arquitectura (crédito de la imagen)En conclusión, la NVIDIA H200, con sus innovadoras características y capacidades de rendimiento, está preparada para redefinir el panorama de la informática con IA. Cuando esté disponible en el segundo trimestre de 2024, el H200 está preparado para empoderar a desarrolladores y empresas de todo el mundo. acelerar el desarrollo y la implementación de aplicaciones de IA Del habla a la inferencia a hiperescala.

Mientras tanto, si está interesado en la empresa de tecnología líder, asegúrese de consultar también nuestro artículo sobre cómo Nvidia y AMD están trabajando en un “chip basado en brazo”.

Crédito de la imagen destacada: Nvidia

Source: NVIDIA H200 se presenta con gran expectación en el ámbito de la IA