Gemma 2 acaba de irrumpir en la escena de la IA 2D y está causando un gran revuelo. Este pequeño modelo demuestra que las cosas buenas vienen en envases pequeños y está generando un verdadero debate en el mundo de la tecnología.

El último invento de Google, Gemma 2 2B, es un modelo de lenguaje compacto con solo 2.600 millones de parámetros. A pesar de su pequeño tamaño, esta máquina de inteligencia artificial está a la altura de sus hermanos mayores. No solo habla por hablar, sino que Gemma 2 2B actúa, igualando e incluso superando a modelos diez veces más grandes.

La brillante actuación de Gemma 2 2B

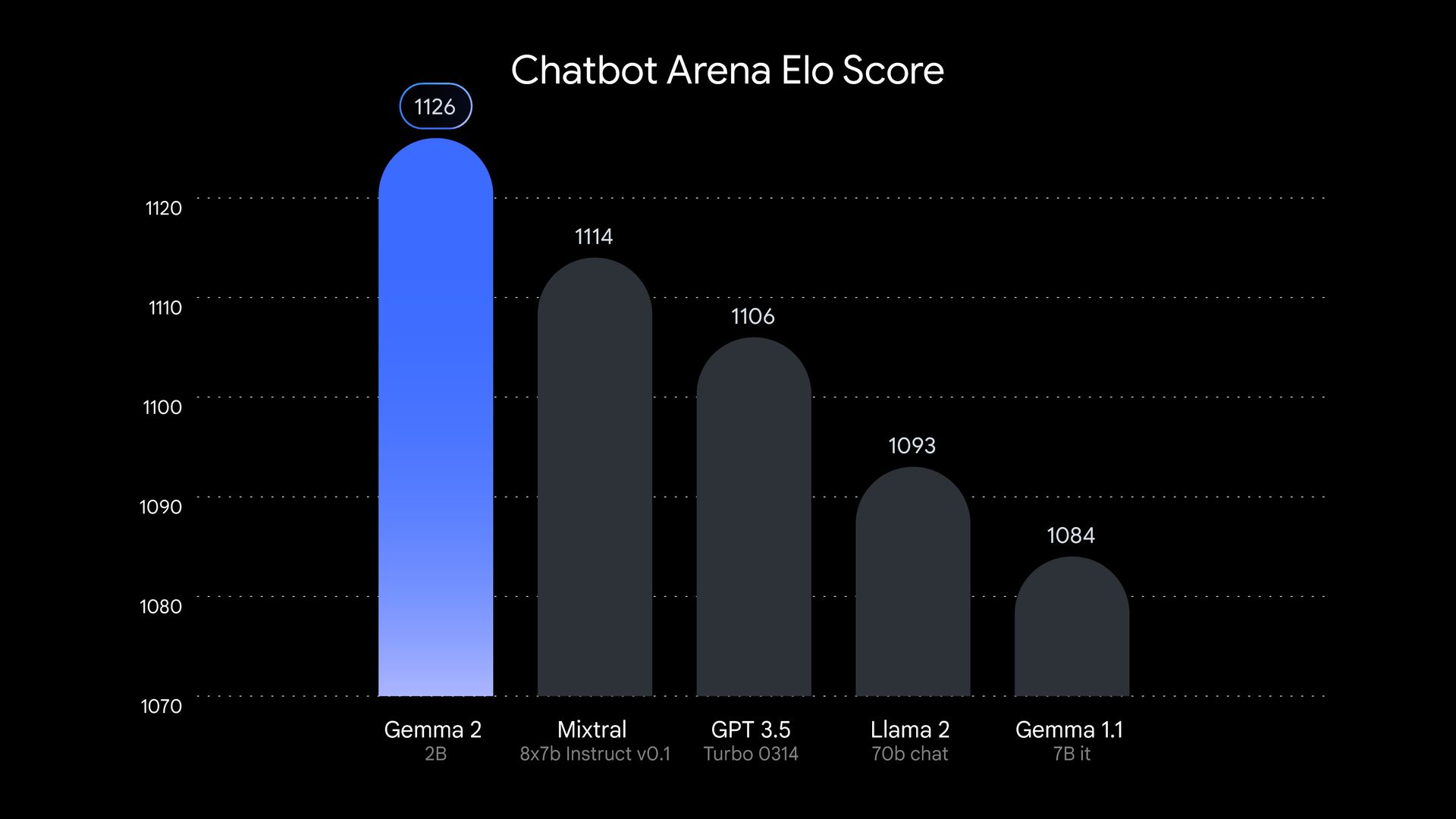

Seamos claros: Gemma 2 2B no es otra fuerza importante en el gran grupo de la IA. Este modelo se puso a prueba y salió brillante. En las pruebas realizadas por LMSYS, un grupo de investigación de IA independiente, Gemma 2 2B obtuvo una puntuación impresionante. 1130 puntos En el área de evaluación. Así es, esta pequeña joya superó a algunos grandes nombres como GPT-3.5-Turbo-0613 y Mixtral-8x7B.

Pero el Gemma 2 2B no se queda ahí. También demuestra que es inteligente en otros ámbitos. En el benchmark MMLU, que pone a prueba la capacidad de un modelo para comprender y razonar sobre diversos temas, el Gemma 2 2B obtuvo 56,1 puntos. En cuanto a la codificación, obtuvo 36,6 puntos en la prueba MBPP. Estas cifras suponen un gran salto con respecto a su predecesor.

¿Cómo ha creado Google esta pequeña maravilla? Gemma 2 2B se entrenó con un conjunto de datos masivo de 2 billones de tokens utilizando el avanzado hardware TPU v5e de Google. Este proceso de entrenamiento permitió al modelo incluir una gran cantidad de información en su estructura compacta. Gemma 2 2B también es multilingüe, lo que amplía sus posibles casos de uso en todo el mundo. Esto lo convierte en una herramienta versátil para desarrolladores e investigadores que trabajan en proyectos internacionales.

El éxito de Gemma 2 2B desafía la idea de que, en IA, cuanto más grande, mejor. Su impresionante rendimiento demuestra que, con las técnicas de entrenamiento adecuadas, arquitecturas eficientes y datos de alta calidad, los modelos más pequeños pueden superar con creces su categoría de peso. Este desarrollo podría cambiar el enfoque de la investigación en IA, pasando de la creación de modelos más grandes a la mejora de modelos más pequeños y eficientes. Se trata de un cambio que podría tener implicaciones de gran alcance para el campo y, potencialmente, hacer que la IA sea más accesible y respetuosa con el medio ambiente.

Puliendo el futuro de la IA

Gemma 2 2D representa una tendencia creciente en la IA hacia modelos más eficientes. A medida que aumentan las preocupaciones sobre el impacto ambiental y la accesibilidad de los modelos de lenguaje de gran tamaño, las empresas de tecnología buscan formas de crear sistemas más pequeños que puedan ejecutarse en hardware cotidiano.

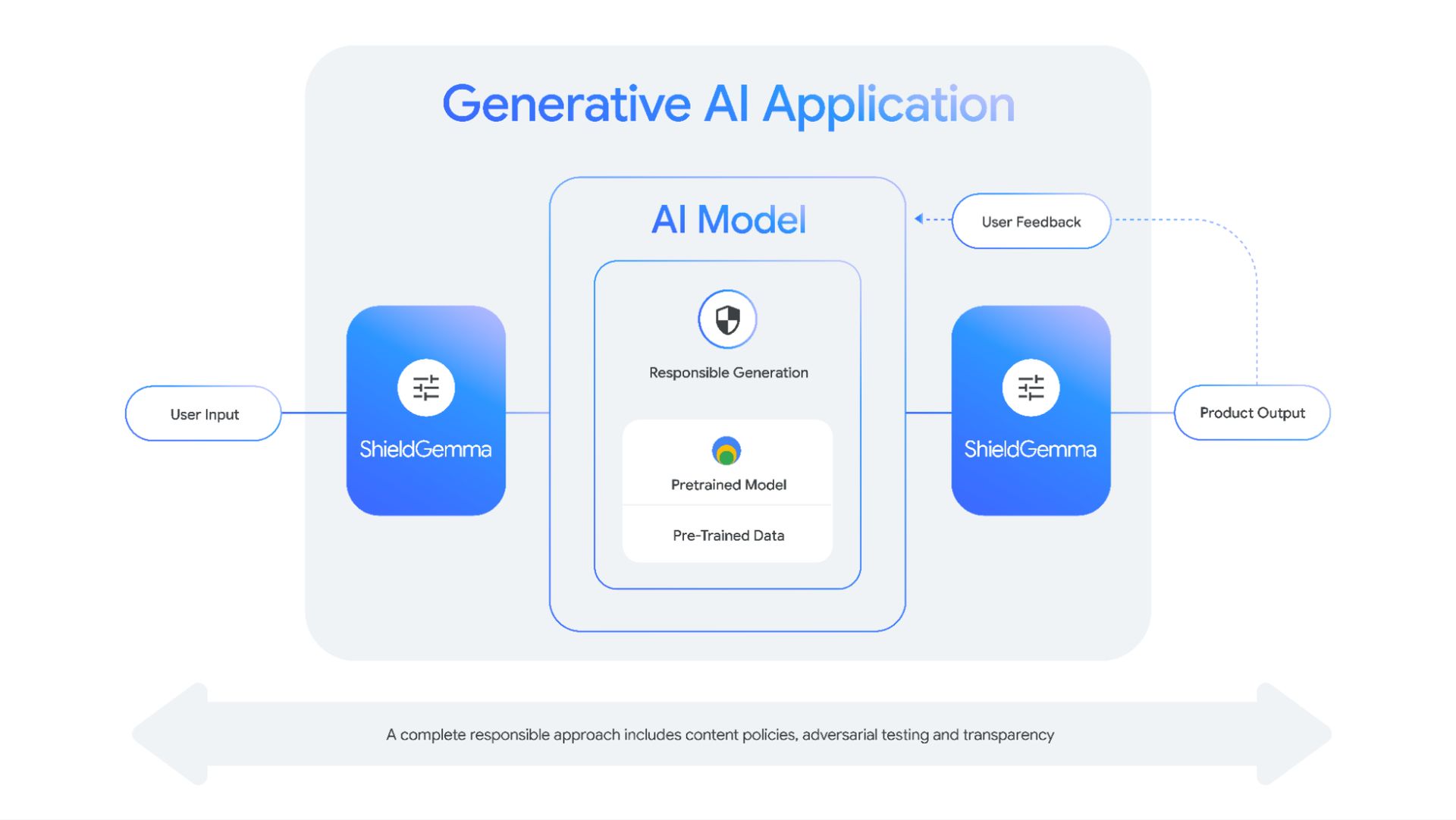

El éxito de Gemma 2 2D también pone de relieve la importancia de las técnicas de compresión y destilación de modelos. Al condensar eficazmente el conocimiento de modelos más grandes en modelos más pequeños, los investigadores pueden crear herramientas de IA más accesibles sin sacrificar el rendimiento.

Este enfoque no solo reduce la potencia computacional necesaria para ejecutar estos modelos, sino que también aborda las preocupaciones sobre el impacto ambiental del entrenamiento y la ejecución de grandes sistemas de IA. Se trata de una situación beneficiosa para todos que podría determinar el futuro del desarrollo de la IA.

Gemma 2 2B demuestra que, cuando se trata de IA, lo que importa no es el tamaño, sino cómo se utiliza. Este pequeño pero potente modelo desafía nuestras suposiciones sobre la IA y allana el camino para una nueva generación de sistemas de IA eficientes, potentes y accesibles. Está claro que esta pequeña joya brillará en el mundo de la IA.

Crédito de la imagen destacada: Google

Source: El tamaño no importa: Gemma 2 2B demuestra que la IA puede pensar en pequeño