Los modelos de lenguaje tienen revolucionado varios campos con sus capacidades avanzadas, dejando a muchas personas con preguntas como cómo usar Google MusicLM y los modelos GPT de OpenAI, que incluyen ChatGPT y Códice, han jugado un papel importante en esta disrupción. Estos modelos tienen la capacidad de generar texto y código de manera eficiente en función de un mensaje determinado. entrenado en vastos conjuntos de datosse pueden aplicar a numerosas tareas de procesamiento del lenguaje natural (NLP), como análisis de sentimientos, sistemas de chatbot, resumen, traducción automática, y clasificación de documentos.

Si bien estos modelos tienen sus limitaciones, ofrecen un vistazo al potencial de los modelos de lenguaje comprender idiomas y desarrollar aplicaciones que puedan mejorar la vida humana. Si bien existen preocupaciones con respecto a su potencial para reemplazar a los humanos en varios dominios, la idea subyacente es aumentar la productividad y proporcionar nuevas formas de explorar y comprender el lenguaje como un todo.

Dado el papel fundamental que juega el lenguaje en la civilización humana, se vuelve imperativo construir modelos de lenguaje que puedan decodificar descripciones textuales y realizar tareas como generar texto, imágenes, audio e incluso música. En este artículo, nos centraremos principalmente en modelos de lenguaje musicalque son similares a modelos como ChatGPT y dall-e, pero en lugar de generar texto o imágenes, están diseñados para crear música.

La música es una forma de arte compleja y dinámica. Implica la orquestación de múltiples instrumentos musicales que armonizan para crear una experiencia contextual. Desde notas y acordes individuales hasta elementos del habla como fonemas y sílabas, la música abarca una amplia gama de componentes. Desarrollando un modelo matematico capaz de extraer información de un conjunto de datos tan diverso es una tarea formidable. Sin embargo, una vez que se establece dicho modelo, puede generar un audio realista similar al que pueden producir los humanos.

Con todo esto en mente, profundicemos en el concepto central de los modelos de lenguaje musical y exploremos cómo permiten la generación de música. Mientras tanto, si está interesado en subir de nivel su juego de música, también puede ver cómo usar Discord Soundboard y agregarle nuevos sonidos.

Comprender los modelos de lenguaje musical y cómo usar Google MusicLM

MusicLM utiliza varias técnicas de aprendizaje automático, como el aprendizaje profundo y el procesamiento del lenguaje natural, para analizar datos y descubrir representaciones ocultas que facilitan la generación de música. Estos modelos aprovechan conjuntos de datos específicos de la música para extraer información, identificar patrones y aprender un amplio espectro de estilos y géneros musicales.

MusicLM tiene el potencial de automatizar una variedad de tareas, que incluyen escribir partituras musicales analizando la música existente, recomendar nuevas progresiones de acordeso incluso generando sonidos novedosos. En última instancia, puede introducir nuevas formas de música expresión y creatividad, sirviendo como una herramienta valiosa para mejorar las habilidades de los músicos y facilitar la educación musical.

Presentamos Google MusicLM

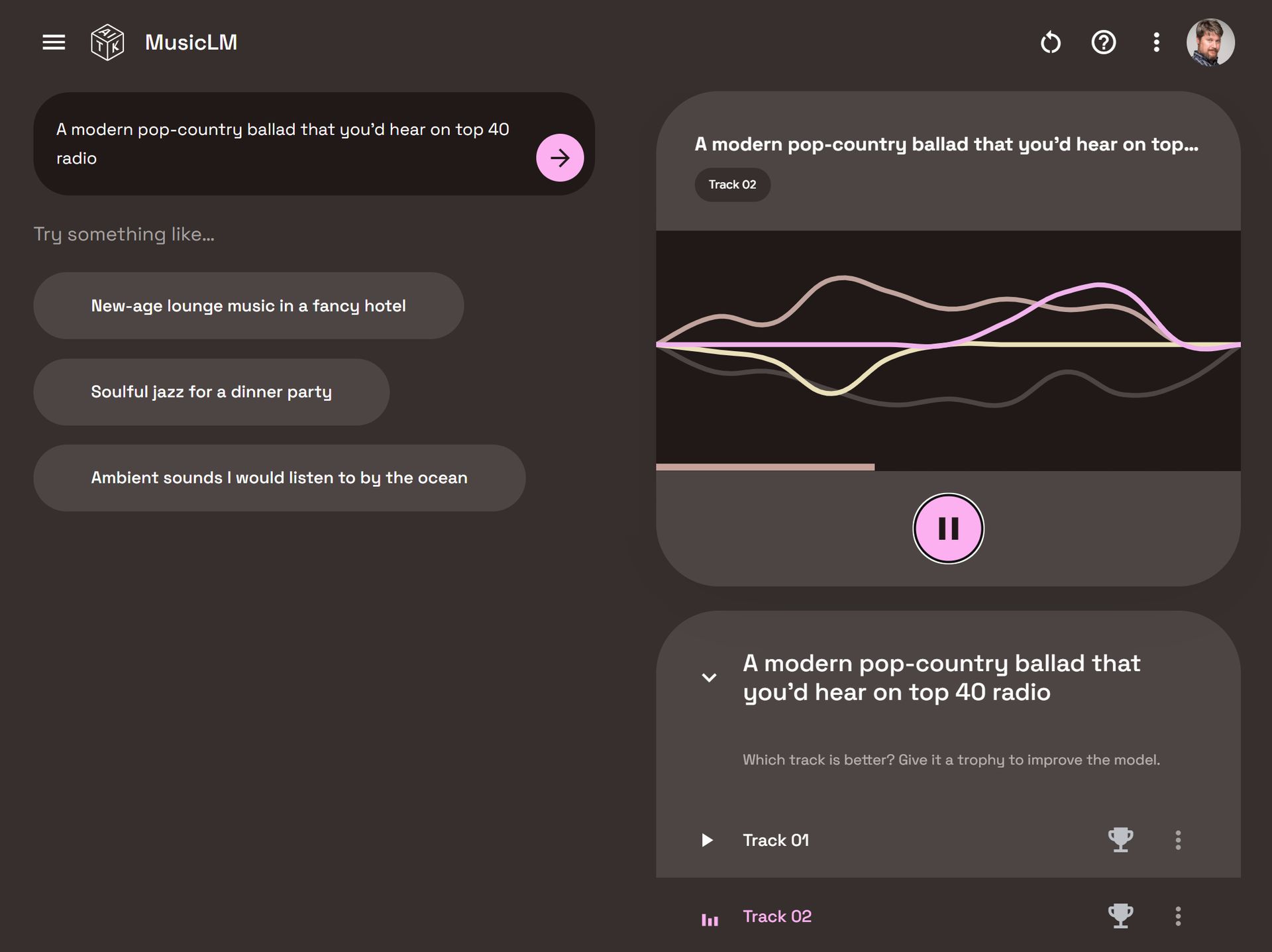

Google MusicLM es un modelo de lenguaje dedicado diseñado específicamente para generar música basada en descripciones de texto. Por ejemplo, al proporcionar un mensaje como “una melodía de guitarra relajante en un riff de compás de 6/8”, el modelo puede producir la música correspondiente.

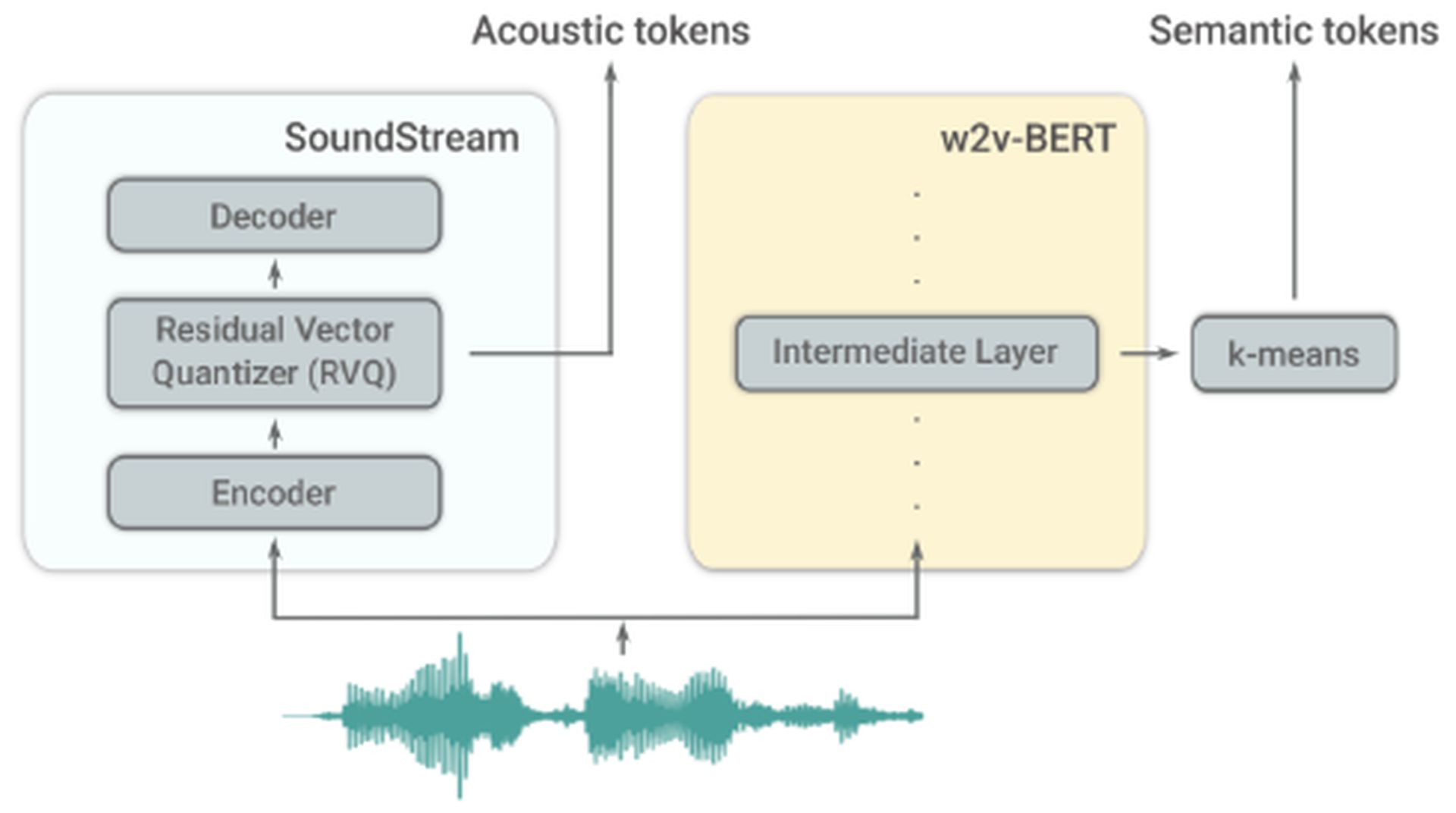

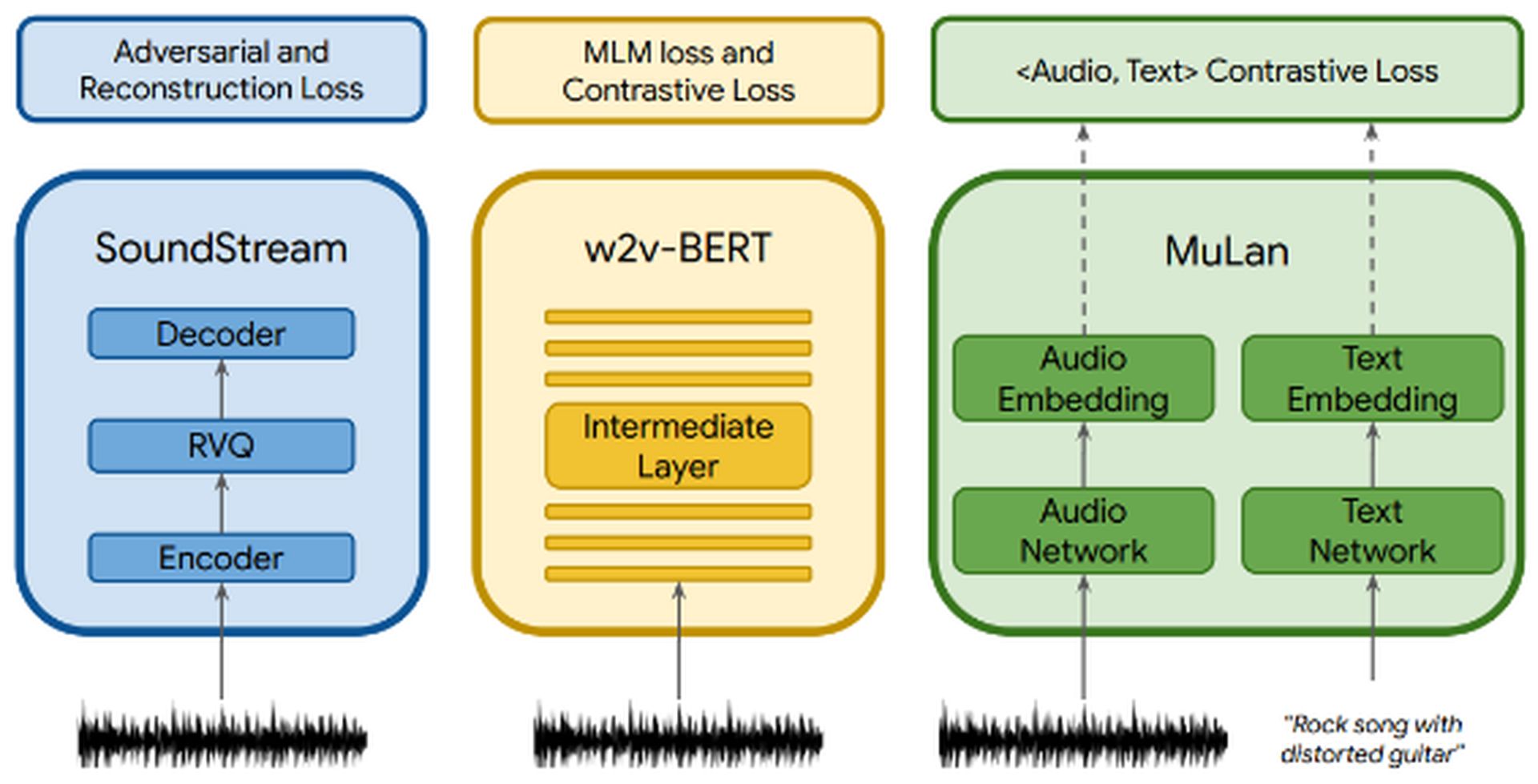

MusicLM se basa en AudioLM, otro modelo de lenguaje desarrollado por Google. AudioLM se enfoca en generar alta calidad y inteligible Continuaciones de discurso y música de piano. Logra esto convirtiendo el audio de entrada en una serie de tokens discretos y generar secuencias de audio con consistencia a largo plazo. AudioLM emplea dos tokenizadores: el tokenizador SoundStream, que produce fichas acústicas, y el tokenizador w2v-BERT, que genera tokens semánticos. Estos tokenizadores juegan un papel crucial en la extracción de información.

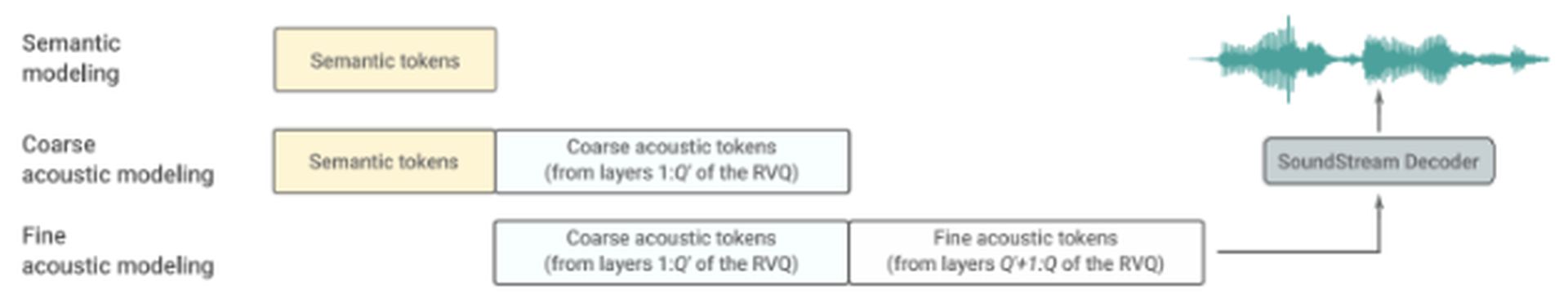

AudioLM consta de tres etapas jerárquicas:

- Modelado semántico: Esta etapa se enfoca en capturar la coherencia estructural a largo plazo. Extrae la estructura de alto nivel de la señal de entrada.

- Modelado acústico grueso: Aquí, el modelo produce tokens acústicos, que luego se concatenan o condicionan en tokens semánticos.

- Modelado acústico fino: Al audio final se le da más profundidad en esta etapa, que involucra el procesamiento de tokens acústicos gruesos con tokens acústicos finos. El decodificador SoundStream utiliza estos tokens acústicos para recrear una forma de onda.

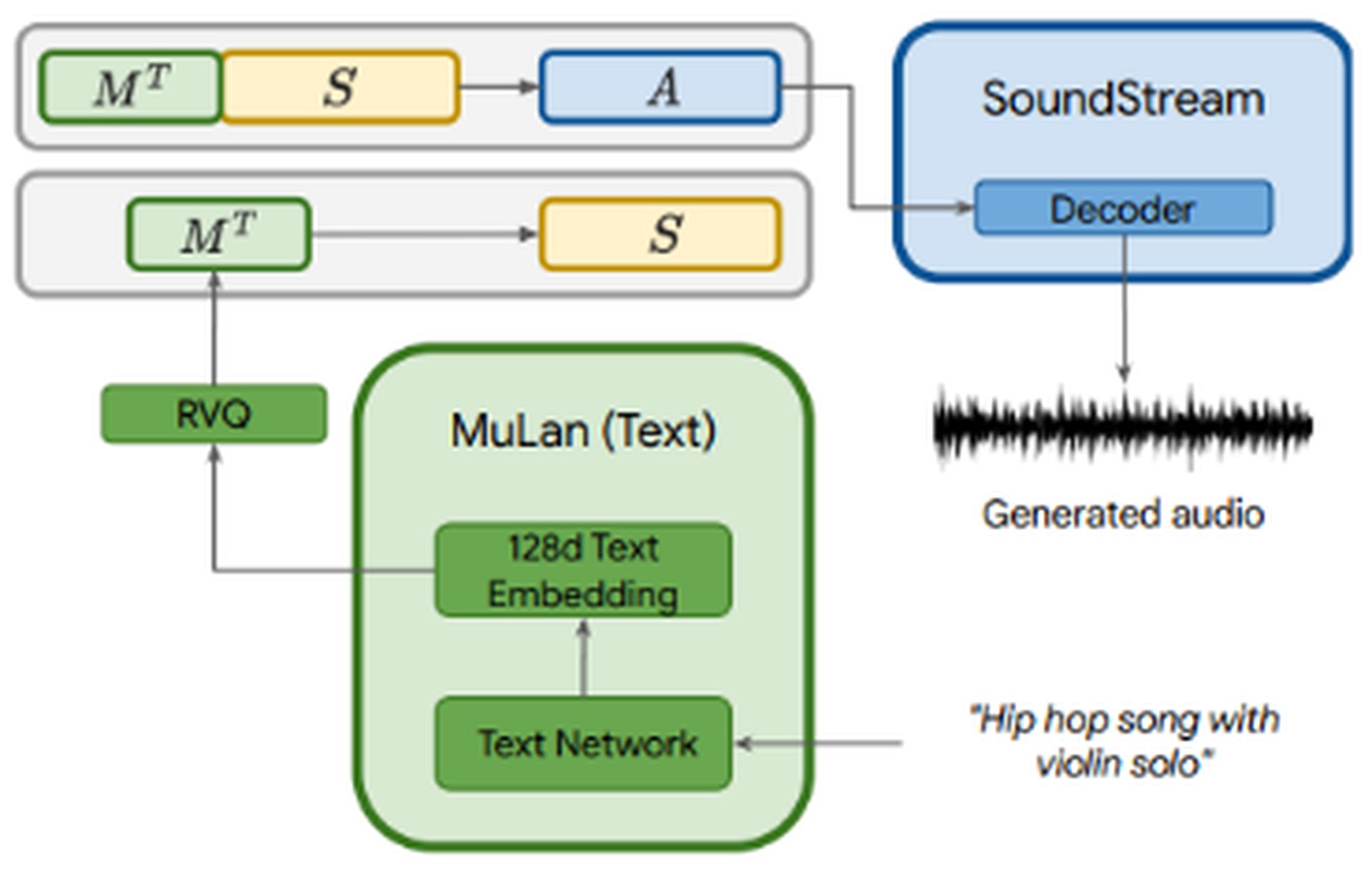

MusicLM aprovecha los AudioLM modelado autorregresivo de múltiples etapas como su componente generativo, al mismo tiempo que incorpora condicionamiento de texto. El archivo de audio se pasa a través de tres componentes: SoundStream, w2v-BERT, y MuLan. SoundStream y w2v-BERT procesan y tokenizan la señal de audio de entrada, mientras que MuLan representa un modelo de integración conjunto para música y texto. MuLan consta de dos torres empotradasuno para cada modalidad (texto y audio).

Mientras el audio se envía a los tres componentes, el la descripción del texto solo se introduce en MuLan. Las incrustaciones de MuLan se cuantifican para proporcionar una representación estandarizada basado en tokens discretos tanto para la señal de acondicionamiento como para el audio. La salida de MuLan luego se alimenta al etapa de modelado semántico, donde el modelo aprende la asignación de tokens de audio a tokens semánticos. El proceso posterior se parece al de AudioLM.

MusicLM, basado en AudioLM y MuLan, ofrece tres ventajas clave:

- Generación musical basada en descripciones de texto.

- Incorporación de melodías de entrada para ampliar la funcionalidad. Por ejemplo, al proporcionar una melodía de tarareo e indicarle a MusicLM que la convierta en un riff de guitarra, el modelo puede generar la salida deseada.

- Generación de secuencias largas para cualquier instrumento musical.

conjunto de datos

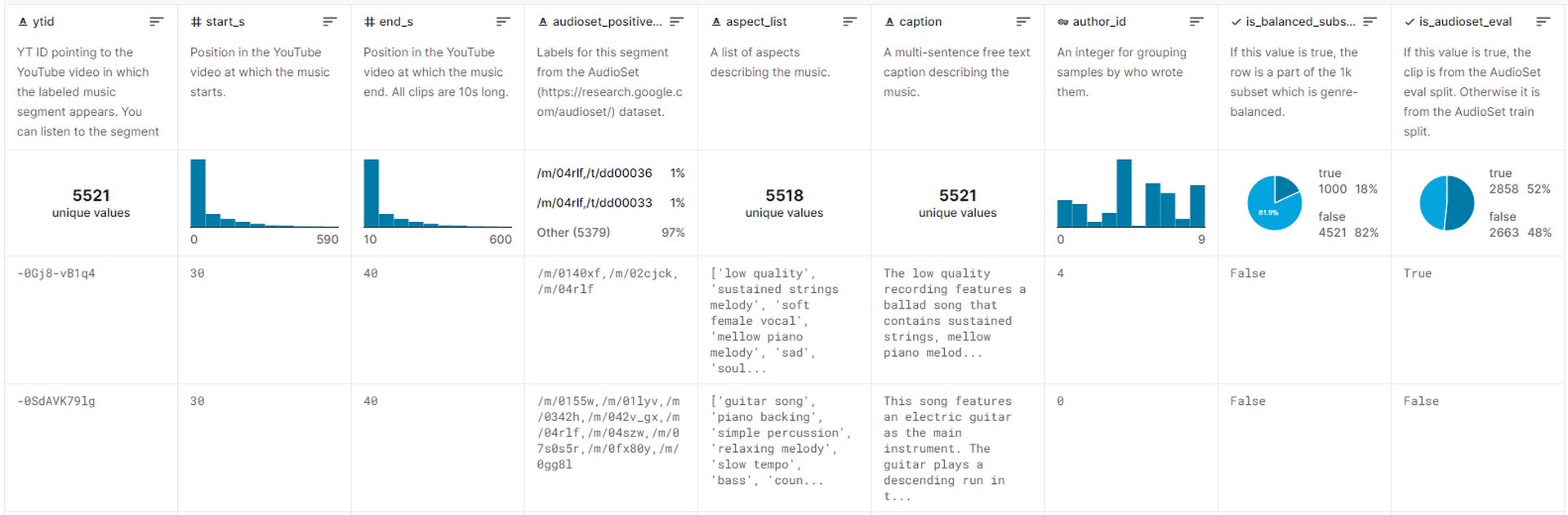

El conjunto de datos utilizado para entrenar MusicLM comprende aproximadamente 5.500 pares de música y texto. Este conjunto de datos incluye más 200.000 horas de músicaacompañado por descripciones de texto enriquecido proporcionada por expertos humanos. Google ha lanzado este conjunto de datos en Kaggle, llamado MusicCaps, y actualmente el público puede acceder a él.

Generación de música con MusicLM

Desafortunadamente, Google actualmente no tiene planes de distribuir modelos relacionados con MusicLM, citando la necesidad de trabajo adicional. Sin embargo, el libro blanco publicado por Google proporciona numerosos ejemplos que demuestran cómo se puede generar música utilizando descripciones de texto.

Aquí hay varios enfoques para generar música con MusicLM:

- Subtítulos enriquecidos: Proporcionando descripciones detalladas como “La banda sonora principal de un juego de arcade. Es de ritmo rápido y optimista, con un pegadizo riff de guitarra eléctrica. La música es repetitiva y fácil de recordar, pero con sonidos inesperados como choques de platillos o redobles de tambores”, MusicLM puede crear música que se alinee con contextos y requisitos específicos.

- Larga generación: Este enfoque implica generar audio continuo y de alta fidelidad durante períodos prolongados, como 5 minutos. Mediante el uso de indicaciones como “Heavy metal” o “reggae calmante”, los usuarios pueden obtener música dentro del género y estilo deseado.

- Modo historia: Una característica notable de MusicLM es la capacidad de generar una secuencia de música basada en una serie de indicaciones de texto. Por ejemplo, especificando diferentes intervalos de tiempo y actividades correspondientes como “hora de meditar (0:00-0:15)“, “hora de despertar (0:15-0:30)“, y así sucesivamente, los usuarios pueden orquestar un viaje musical.

- Acondicionamiento de texto y melodía: Este enfoque permite a los usuarios producir música que se adhiere a una melodía proporcionada, como una secuencia de tarareo o silbido respetando el mensaje de texto dado. Esencialmente, convierte una secuencia de audio en la salida deseada.

- Acondicionamiento de la leyenda de la pintura: MusicLM puede generar música basada en descripciones de pinturas. Por ejemplo, al proporcionar una descripción de la famosa obra de arte de Salvador Dalí “La persistencia de la memoria“, el modelo puede crear música inspirada en los conceptos e imágenes de la pintura.

- Lugares: Las descripciones de lugares o entornos específicos pueden servir como indicaciones para generar música. Por ejemplo, usando una descripción como “un tiempo soleado y tranquilo en la playa“, MusicLM puede generar música que encapsule la esencia de ese entorno.

Ejemplos adicionales incluyen la generación de audio de 10 segundos a partir de texto, teniendo en cuenta los niveles de experiencia de los músicos, las épocas e incluso los solos de acordeón. MusicLM ofrece un conjunto versátil de capacidades para generar música en varios dominios y escenarios.

Las impresionantes capacidades de MusicLM para generar musica de alta fidelidad mostrar el notable potencial de la creatividad humana en lugar de confiar únicamente en los algoritmos de IA. Sin embargo, este avance también plantea preocupaciones éticas y puede enfrentar la resistencia de la comunidad musicalsimilar a los modelos de generación de imágenes como Dalle y ChatGPT.

Los investigadores de Google reconocen las cuestiones eticas asociado con un sistema como MusicLM, incluido el potencial para incorporar contenido protegido por derechos de autor a partir de datos de entrenamiento en las canciones generadas. Durante los experimentos, descubrieron que 1% de la música generada por el sistema reprodujo directamente canciones de sus datos de entrenamiento. Este porcentaje se consideró demasiado alto para lanzar MusicLM en su forma actual.

Si bien es poco probable que MusicLM se convierta en una aplicación disponible públicamente en un futuro cercano, podemos anticipar la aparición de modelos de música de código abierto que pueden ser modificados mediante ingeniería inversa por desarrolladores independientes. El futuro tiene emocionantes posibilidades por aprovechar los modelos lingüísticos para mejorar la creatividad y expresión musical al tiempo que garantiza el uso responsable y ético de estas tecnologías.